中國 AI 新創公司 Z.ai 稍早發布了一款專門用於文件理解的多模態 OCR 模型「GLM-OCR」。最讓人驚豔的是,這款模型的參數規模僅有 0.9B(9 億),卻號稱能精準解析並提取複雜的文件排版內容,甚至在多項基準測試中超越了現有的競爭對手。

GLM-OCR 的技術核心基於 GLM-V 編碼器-解碼器架構。它整合了經過大規模圖文資料預訓練的 CogViT 視覺編碼器、高效的輕量級跨模態連接器,以及 GLM-0.5B 語言解碼器。為了提升學習效率與辨識精準度,團隊還導入了多 token 預測(MTP)損失函數。

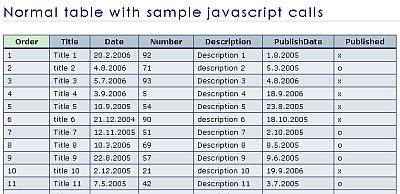

傳統 OCR 遇到表格或註釋時,格式往往會跑掉。但 GLM-OCR 採用基於 PP-DocLayout-V3 的版面分析與平行辨識兩階段流程,能先看懂文件結構,再進行文字與圖片辨識,即使是複雜的技術文件或排版混亂的收據也能搞定,並精準輸出為 HTML 或 JSON 格式。

在 OmniDocBench V1.5 基準測試中,GLM-OCR 拿下了 94.62 的高分。無論是數學公式、表格辨識,還是資訊的結構化提取,都達到了 SOTA(State-of-the-Art,業界頂尖)的水準。

對企業來說,最大的賣點在於「輕量化」。因為參數只有 9 億,GLM-OCR 可以輕鬆在本地端環境執行,並支援 vLLM、SGLang、Ollama 等主流框架。這意味著企業可以在不連網的情況下處理機密文件,大幅降低資料外洩風險。

速度方面也不馬虎。根據測試,在單一硬體環境下,它處理 PDF 文件的速度可達每秒 1.86 頁,處理圖片則為每秒 0.67 張,吞吐量顯著優於同級別模型。

目前 GLM-OCR 已在 Hugging Face 開源。模型本體採用寬鬆的 MIT 授權,不過需注意其中使用的 PP-DocLayoutV3 則適用 Apache 2.0 授權。